- العمل مع التسلسلات

- تحويل النص الخام إلى بيانات التسلسل

- نماذج اللغة

- الشبكات العصبية المتكررة

- تنفيذ الشبكة العصبية المتكررة من الصفر

- التنفيذ المختصر للشبكات العصبية المتكررة

- الانتشار الخلفي عبر الزمن

حتى الآن، ركزنا بشكل أساسي على البيانات ذات الطول الثابت fixed-length data. عند تقديم الانحدار الخطي واللوجستي في القسم 3 والقسم 4 والبيرسيبترون متعددة الطبقات في القسم 5، كان من دواعي سرورنا أن نفترض أن كل متجه للميزات يتكون من عدد ثابت من المكونات حيث تتوافق كل ميزة رقمية مع سمة معينة. يطلق على مجموعات البيانات هذه أحيانًا اسم جدولي tabular، لأنه يمكن ترتيبها في جداول، حيث يحصل كل مثال على صف خاص به، وكل سمة تحصل على عمودها الخاص. بشكل حاسم، مع البيانات المجدولة tabular data، نادرًا ما نفترض أي بُنية معينة فوق الأعمدة.

بعد ذلك، في القسم 7، انتقلنا إلى بيانات الصورة، حيث تتكون المدخلات من قيم البكسل الأولية في كل إحداثي في الصورة. لا تكاد بيانات الصورة تتناسب مع فاتورة مجموعة البيانات الجدولية النموذجية. هناك، احتجنا إلى استدعاء الشبكات العصبية التلافيفية (CNN) للتعامل مع الهيكل الهرمي والثوابت. ومع ذلك، كانت بياناتنا لا تزال ذات طول ثابت. يتم تمثيل كل صورة من صور Fashion-MNIST كشبكة من قيم البكسل . علاوة على ذلك، كان هدفنا تطوير نموذج ينظر إلى صورة واحدة فقط ثم ينتج تنبؤًا واحدًا. ولكن ما الذي يجب أن نفعله عندما نواجه سلسلة من الصور، كما هو الحال في مقطع فيديو، أو عند تكليفنا بإنتاج تنبؤ منظم بشكل تسلسلي، كما في حالة التسميات التوضيحية للصور image captioning؟

تتطلب مهام التعلم التي لا تعد ولا تحصى التعامل مع البيانات المتسلسلة sequential data. يتطلب شرح الصور وتوليف الكلام وتوليد الموسيقى أن تنتج النماذج مخرجات تتكون من تسلسلات. في المجالات الأخرى، مثل توقع السلاسل الزمنية time series prediction وتحليل الفيديو video analysis واسترجاع المعلومات الموسيقية musical information retrieval، يجب أن يتعلم النموذج من المدخلات المتسلسلة. غالبًا ما تنشأ هذه المطالب في وقت واحد: مهام مثل ترجمة مقاطع نصية من لغة طبيعية إلى أخرى، أو الانخراط في حوار، أو التحكم في روبوت، تتطلب نماذج استيعاب وإخراج بيانات منظمة بالتسلسل.

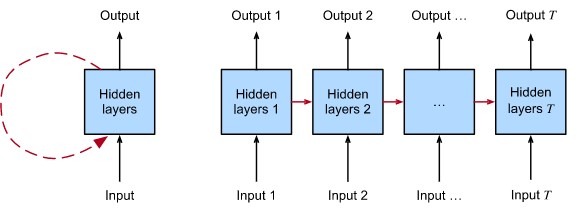

الشبكات العصبية المتكررة (RNNs) هي نماذج التعلم العميق التي تلتقط ديناميكيات التسلسلات عبر الاتصالات المتكررة recurrent connections، والتي يمكن اعتبارها دورات في شبكة العقد. قد يبدو هذا غير منطقي في البداية. بعد كل شيء، فإن الطبيعة المغذية feedforward nature للشبكات العصبية هي التي تجعل ترتيب الحساب واضحًا. ومع ذلك، يتم تحديد الحواف المتكررة بطريقة دقيقة تضمن عدم حدوث مثل هذا الغموض. يتم إلغاء التحكم في الشبكات العصبية المتكررة عبر الخطوات الزمنية time steps (أو خطوات التسلسل sequence steps)، مع تطبيق نفس المعلمات الأساسية في كل خطوة. بينما يتم تطبيق الاتصالات القياسية بشكل متزامن لنشر عمليات تنشيط كل طبقة إلى الطبقة اللاحقة في نفس الخطوة الزمنية، تكون الاتصالات المتكررة ديناميكية، وتمرير المعلومات عبر خطوات الوقت المجاورة. كما يكشف العرض غير المطوي unfolded view في الشكل 9.1، يمكن اعتبار شبكات RNN بمثابة شبكات عصبية تلقائية feedforward neural networks حيث تتم مشاركة معلمات كل طبقة (التقليدية والمتكررة conventional and recurrent) عبر خطوات زمنية.

مثل الشبكات العصبية على نطاق أوسع، تتمتع شبكات RNN بتاريخ طويل يمتد من الانضباط، حيث نشأت كنماذج للدماغ شاعها علماء الإدراك وتم تبنيها لاحقًا كأدوات نمذجة عملية يستخدمها مجتمع التعلم الآلي. كما هو الحال مع التعلم العميق على نطاق أوسع، يتبنى هذا الكتاب منظور التعلم الآلي، مع التركيز على RNNs كأدوات عملية ارتفعت إلى الشعبية في 2010 بسبب النتائج المذهلة في مهام متنوعة مثل التعرف على خط اليد handwriting recognition (Graves et al.، 2008)، الترجمة الآلية machine translation (Sutskever et al.، 2014)، والتعرف على التشخيصات الطبية recognizing medical diagnosis (Lipton et al.، 2016). نوجه القارئ المهتم بمزيد من المواد الأساسية إلى مراجعة شاملة متاحة للجمهور (Lipton et al.، 2015). نلاحظ أيضًا أن التسلسل ليس فريدًا بالنسبة لـ RNNs. على سبيل المثال، يمكن تكييف شبكات CNN التي قدمناها بالفعل للتعامل مع البيانات ذات الطول المتفاوت varying length، على سبيل المثال، الصور ذات الدقة المتفاوتة varying resolution. علاوة على ذلك، تنازلت RNNs مؤخرًا عن حصة كبيرة من السوق لنماذج المحولات transformer models، والتي سيتم تغطيتها في القسم 11. ومع ذلك، ارتفعت RNNs إلى الصدارة كنماذج افتراضية للتعامل مع البنية المتسلسلة المعقدة في التعلم العميق، ولا تزال نماذج أساسية للنمذجة المتسلسلة sequential modeling حتى يومنا هذا. ترتبط قصص RNNs ونمذجة التسلسل ارتباطًا وثيقًا، وهذا فصل عن أبجديات مشاكل نمذجة التسلسل كما هو فصل حول RNNs.

مهدت إحدى الأفكار الرئيسية الطريق لثورة في نمذجة التسلسل. في حين أن المدخلات والأهداف للعديد من المهام الأساسية في التعلم الآلي لا يمكن بسهولة تمثيلها كمتجهات ذات طول ثابت fixed length vectors، إلا أنه يمكن تمثيلها في كثير من الأحيان على أنها متواليات متغيرة الطول لمتجهات الطول الثابت. على سبيل المثال، يمكن تمثيل المستندات كتسلسل من الكلمات. غالبًا ما يمكن تمثيل السجلات الطبية كتسلسل للأحداث (لقاءات، أدوية، إجراءات، اختبارات معملية، تشخيصات). يمكن تمثيل مقاطع الفيديو كتسلسلات متفاوتة الطول للصور الثابتة.

بينما ظهرت نماذج التسلسل في مجالات تطبيق لا حصر لها، فإن البحث الأساسي في المنطقة كان مدفوعًا في الغالب بالتقدم في المهام الأساسية في معالجة اللغة الطبيعية natural language processing. وبالتالي، خلال هذا الفصل، سنركز عرضنا وأمثلة على البيانات النصية text data. إذا فهمت هذه الأمثلة، فإن تطبيق هذه النماذج على أساليب البيانات الأخرى يجب أن يكون بسيطًا نسبيًا. في الأقسام القليلة التالية، نقدم تدوينًا أساسيًا للتسلسلات وبعض مقاييس التقييم لتقييم جودة مخرجات النموذج المنظم بشكل تسلسلي. بعد ذلك، نناقش المفاهيم الأساسية لنموذج اللغة ونستخدم هذه المناقشة لتحفيز نماذج RNN الأولى لدينا. أخيرًا، نصف طريقة حساب التدرجات عند الانتشار الخلفي من خلال شبكات RNN واستكشاف بعض التحديات التي غالبًا ما تتم مواجهتها عند تدريب مثل هذه الشبكات، وتحفيز بُنى RNN الحديثة التي ستتبع في القسم 10.